Пользователь Reddit обнаружил встроенные Apple Intelligence в бета-версии macOS, в которых Apple предписывает функции Smart Reply не «галлюцинировать».

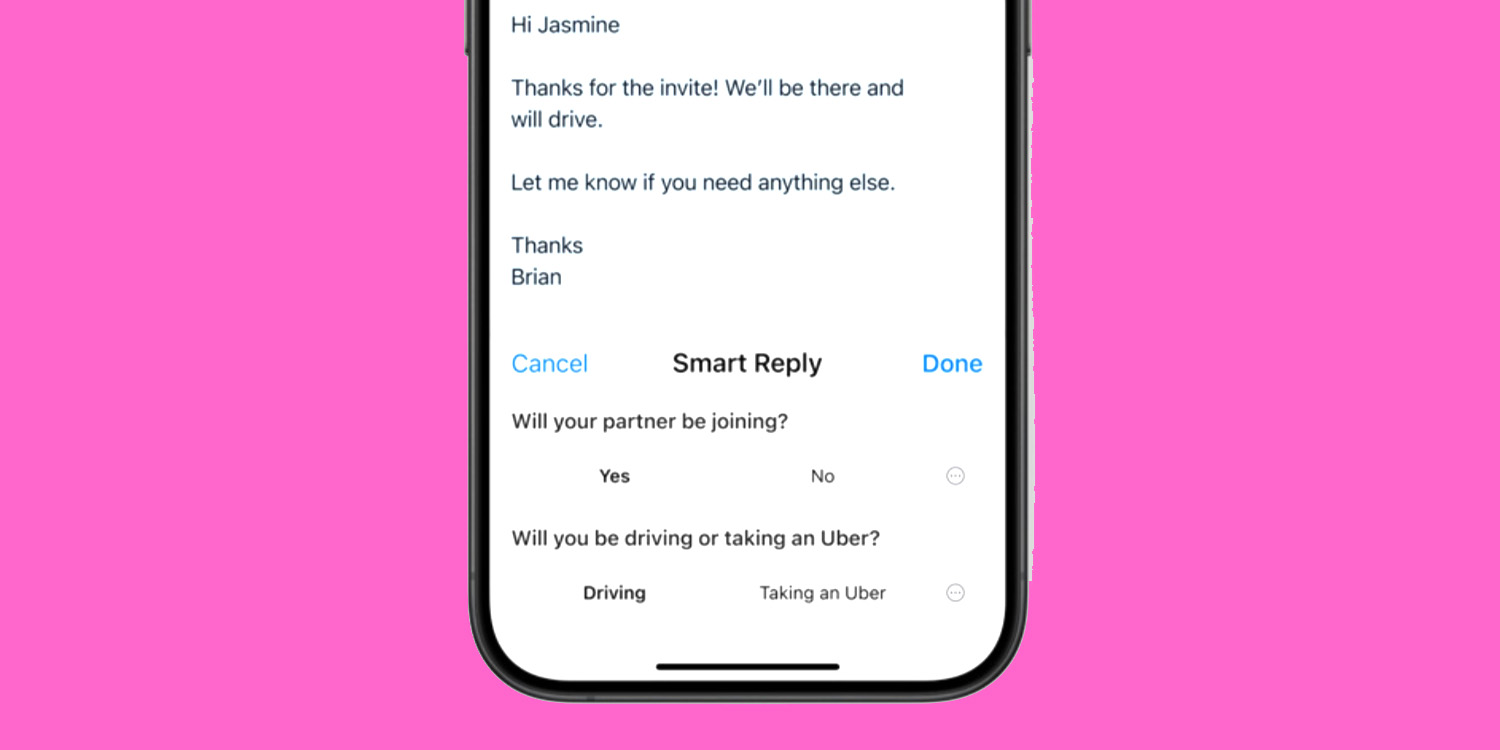

Smart Reply помогает отвечать на электронные письма и сообщения, проверяя заданные вопросы, предлагая вам ответы и затем формулируя ответ…

Smart Reply

Вот как Apple описывает эту функцию:

Используйте Smart Reply в «Почте», чтобы быстро составить ответ на электронное письмо со всеми нужными деталями. Apple Intelligence может определять вопросы, которые вам задавали в письме, и предлагать релевантные варианты для включения в ваш ответ. Всего за несколько нажатий вы будете готовы отправить ответ с ответами на ключевые вопросы.

Встроенные подсказки Apple Intelligence

Генеративные системы ИИ получают указания к действию с помощью текста, известного как подсказки. Некоторые из этих подсказок предоставляются пользователями, а другие написаны разработчиком и встроены в модель. Например, большинство моделей имеют встроенные инструкции или предварительные подсказки, предписывающие им не предлагать ничего, что могло бы нанести вред людям.

Пользователь Reddit devanxd2000 обнаружил набор JSON-файлов в бета-версии macOS 15.1, которые, по-видимому, являются инструкциями Apple по предварительной подсказке для функции Smart Reply.

Вы — полезный почтовый ассистент, который может помочь определить релевантные вопросы из данного письма и короткого фрагмента ответа.

Учитывая письмо и фрагмент ответа, задавайте релевантные вопросы, которые явно заданы в письме. Ответы на эти вопросы будет выбирать получатель, что поможет уменьшить «галлюцинации» при составлении ответа.

Пожалуйста, выводите лучшие вопросы вместе с набором возможных ответов/вариантов для каждого из этих вопросов. Не задавайте вопросы, на которые уже есть ответ во фрагменте ответа. Вопросы должны быть короткими, не более 8 слов. Выводите результат в формате JSON со списком словарей, содержащих ключи «вопрос» и «ответы». Если в письме нет заданных вопросов, выводите пустой список. Выводите только валидный JSON-контент и ничего более.

«Не галлюцинировать»

The Verge обнаружил конкретные инструкции, предписывающие ИИ не «галлюцинировать»:

Не галлюцинируйте. Не выдумывайте фактическую информацию.

Мнение 9to5Mac

Инструкции «не галлюцинировать» кажутся… оптимистичными! Причина, по которой генеративные системы ИИ «галлюцинируют» (то есть выдумывают ложную информацию), заключается в том, что они не понимают содержания и, следовательно, не имеют надежного способа узнать, правдив ли их результат.

Apple полностью осознает, что результаты ее ИИ-систем будут находиться под пристальным вниманием, так может быть, это просто случай, когда «любая помощь хороша»? С этими подсказками, по крайней мере, система ИИ понимает важность не выдумывать информацию, даже если она не может ей следовать.

Изображение: коллаж 9to5Mac с использованием изображения от Apple