Когда на прошлой неделе я попробовал очки Ray-Ban Meta, я назвал функции ИИ на данный момент в основном трюком, но они по-прежнему вызывали у меня волнение по поводу будущих Apple Glasses.

Несколько комментаторов отметили, что очки работают несколько лучше при последующих вопросах, и я попробовал эту функцию во время еще одной прогулки, что выявило смесь удачных и неудачных результатов. Но что действительно отсутствует в настоящее время, так это интеграция…

Очки не имеют доступа к GPS подключенного iPhone, поэтому не могут использовать местоположение в качестве подсказки. У них нет доступа к сторонним приложениям, поэтому они не могут извлекать из них данные для таких вещей, как общественный транспорт. Что нам действительно нужно здесь, так это полностью подключенная экосистема — и я могу подумать о компании, которая специализируется на этом…

Долгосрочная мечта об ИИ

Я уже писал о своей долгосрочной мечте о полностью связанной Siri. Почти десять лет назад я мечтал иметь возможность давать ей команду вроде «Организовать обед с Сэмом на следующей неделе» и позволить ей разобраться со всеми деталями.

Siri знает, кто такой Сэм, так что с этим проблем нет. У нее есть доступ к моему календарю, так что она знает, когда у меня есть свободные слоты для обеда. Далее ей нужно знать, когда у Сэма есть свободные слоты для обеда.

Это не должно быть сложно. Microsoft Outlook уже много лет предлагает делегированный доступ к календарям, где коллеги по работе могут проверять календари друг друга на уровне «свободен/занят», а авторизованные лица могут добавлять встречи. Так что нам нужен эквивалент iCloud.

Мой iPhone проверяет календарь iCloud Сэма на наличие свободных слотов для обеда и сопоставляет их с моими. Он обнаруживает, что мы оба свободны в среду, и назначает обед.

И это могло бы сделать еще больше. Мой iPhone мог бы легко запомнить мои любимые закусочные, а также закусочные Сэма, и найти ту, которая нравится нам обоим. Затем он мог бы зайти в систему бронирования ресторана, чтобы сделать заказ.

OpenAI только что еще раз продемонстрировала будущее ИИ в виде GPT-4o, версии ChatGPT, которая может использовать камеры наших iPhone, чтобы видеть, что нас окружает (а также Screen Recorder для просмотра того, что находится на нашем экране в других приложениях).

Эта способность видеть окружающее, конечно, гораздо удобнее выполнять с помощью умных очков. Нам не нужно держать телефон, мы просто спрашиваем наши очки.

Задаем последующие вопросы очках Meta

Я отметил, что очки Ray-Ban Meta дали мне в основном общую информацию об окружающем, за некоторыми исключениями. Задание последующих вопросов выявило смесь впечатляющих и невпечатляющих результатов, а также некоторые, которые просто указывают на функции, которые будут существовать, но пока нет.

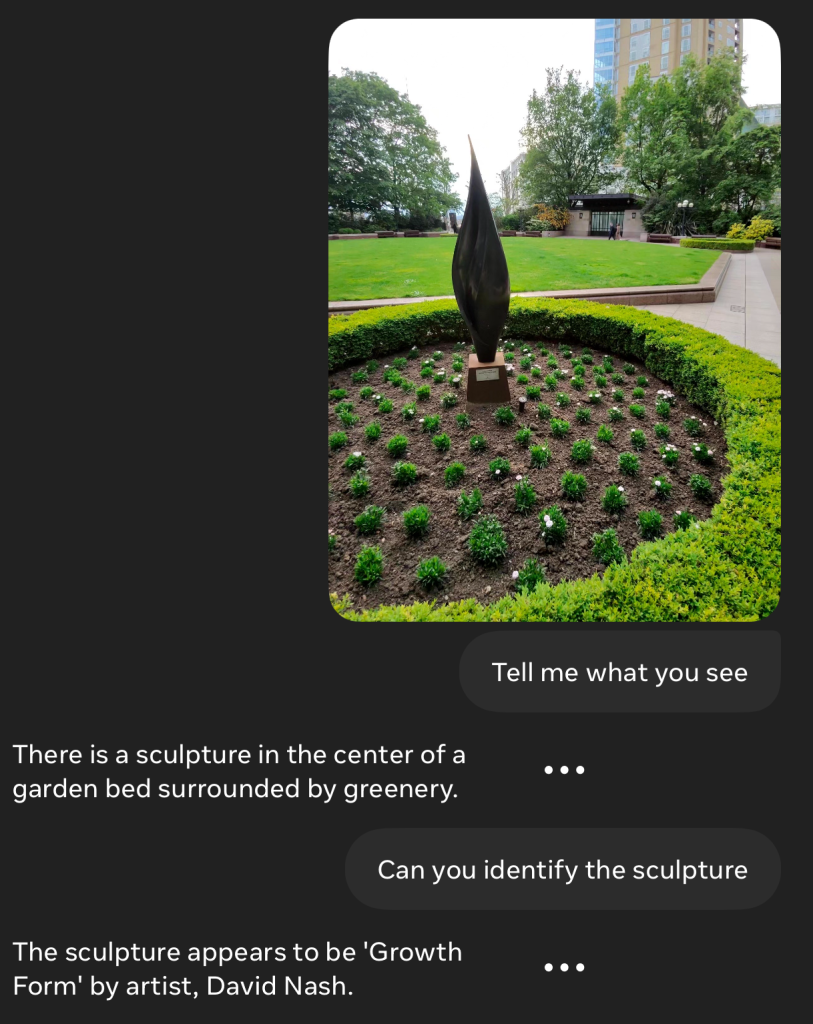

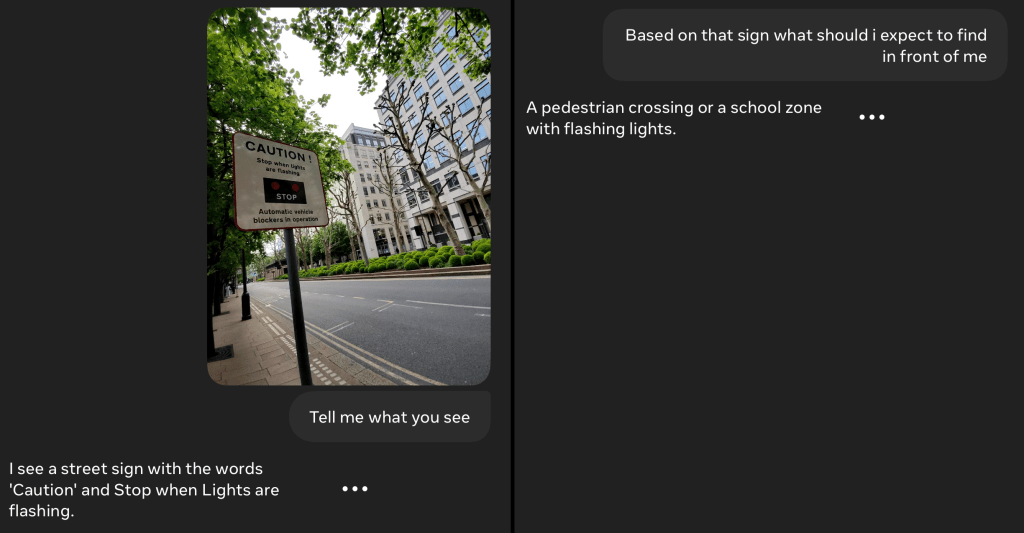

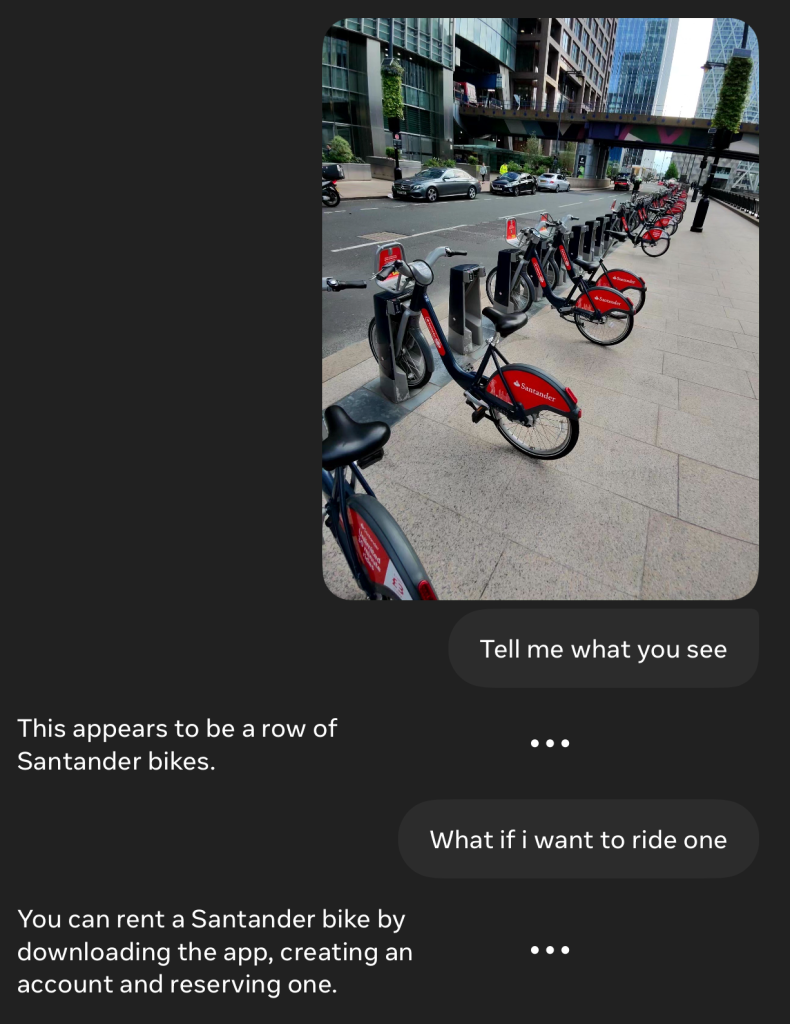

Этот пример был невероятно впечатляющим, особенно учитывая, что я уверен, что вывеска была слишком маленькой, чтобы разглядеть текст, и она даже не знала, в каком городе мы находимся:

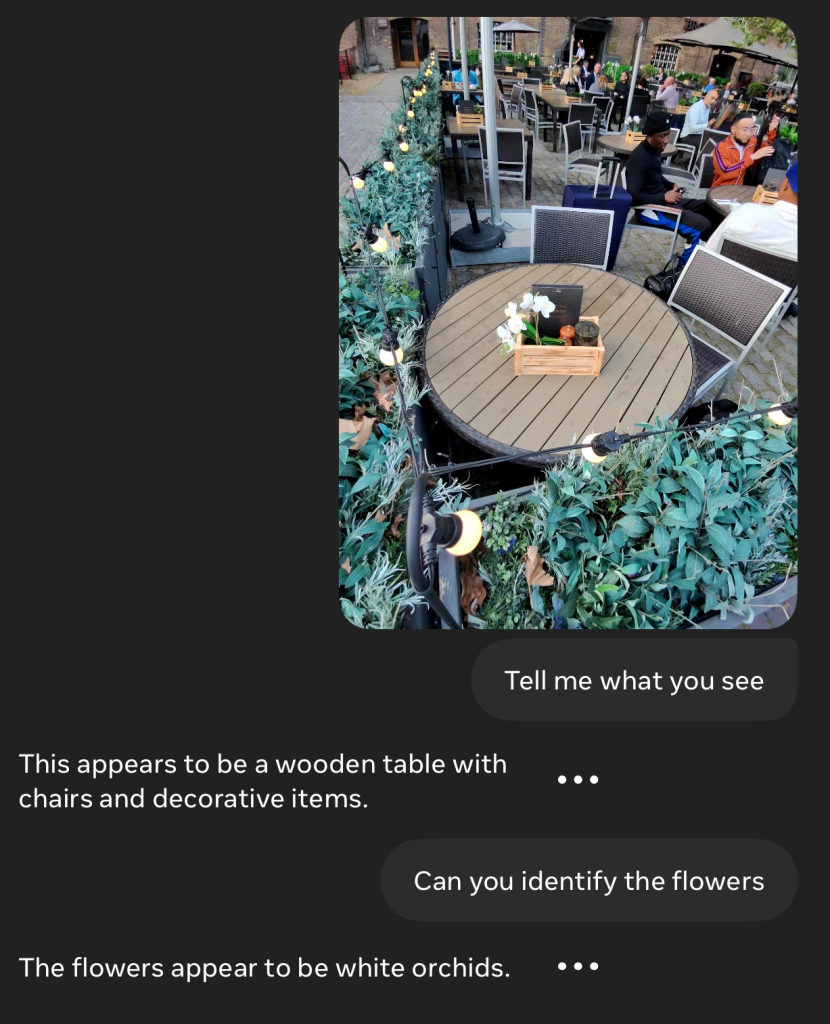

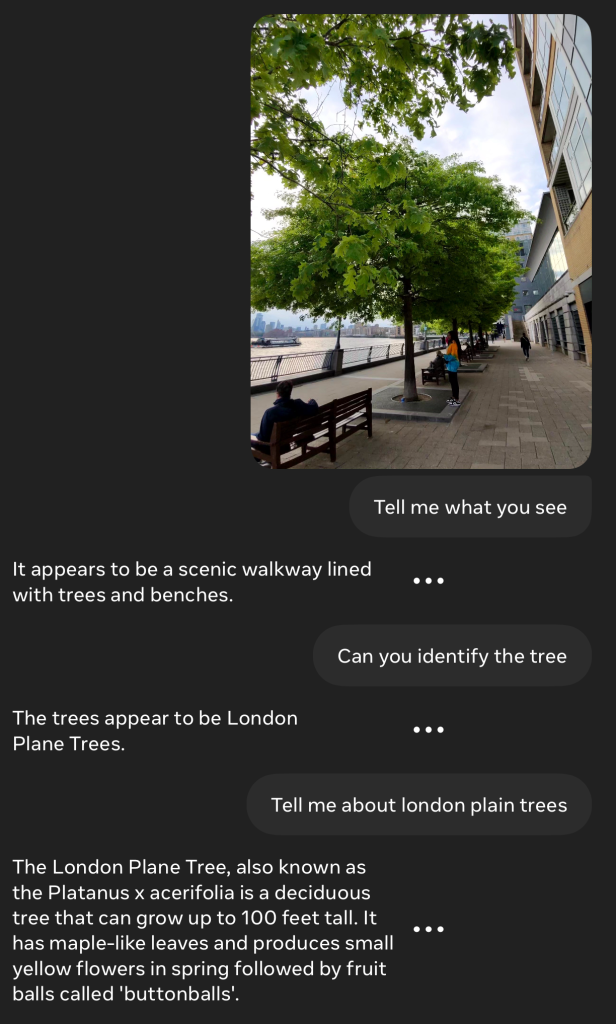

В прошлый раз я отметил, что они не определяли растения конкретно, но некоторые последующие вопросы показывают, что они иногда могут преуспевать в этом.

Также впечатляет:

Неплохая догадка:

Она также неплохо справилась с этим последующим вопросом, хотя опять же, интеграция будет здесь ключевой — в идеале она сможет загрузить/открыть приложение на моем телефоне.

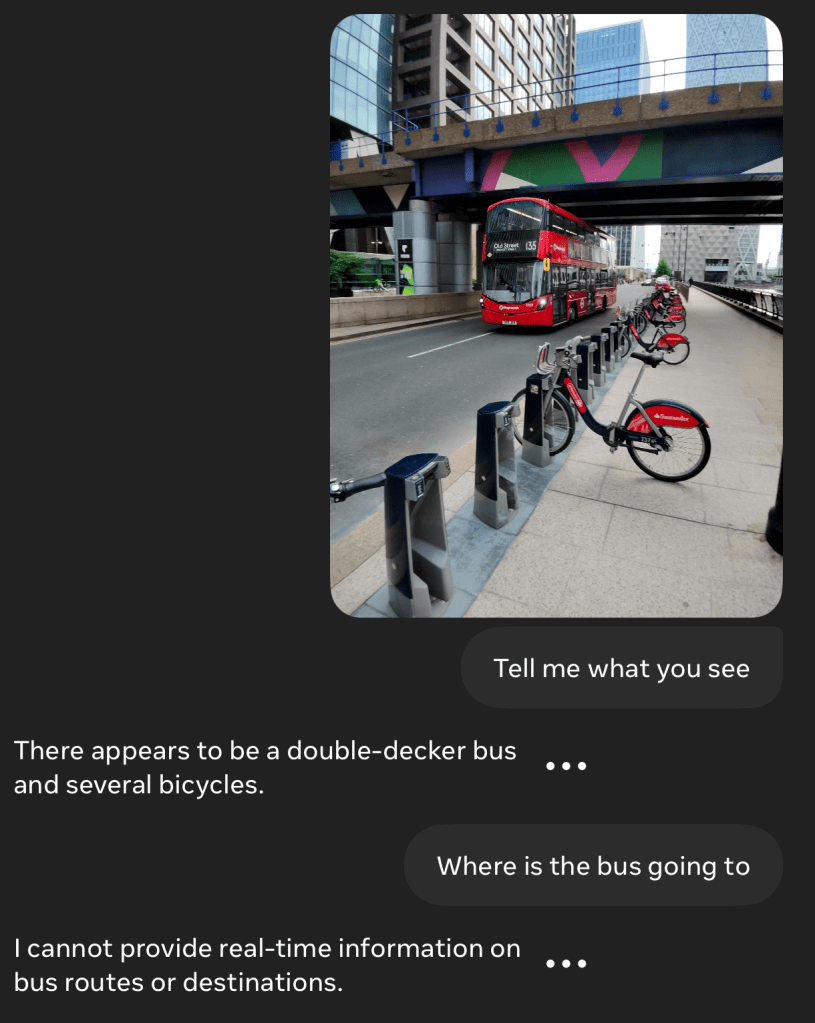

Следующий пример действительно демонстрирует необходимость того, чтобы все работало вместе. Я показал ей автобус и спросил, куда он едет. Она должна была бы прочитать доску назначения и номер, а у меня есть CityMapper на телефоне, но этот обмен был мучительным!

Я сказал ей, что маршрут автобуса — 135, но поскольку у нее нет доступа к GPS iPhone, она даже не знала, что находится в Лондоне.

Наконец, когда я сказал ей, что мы в Лондоне, она справилась!

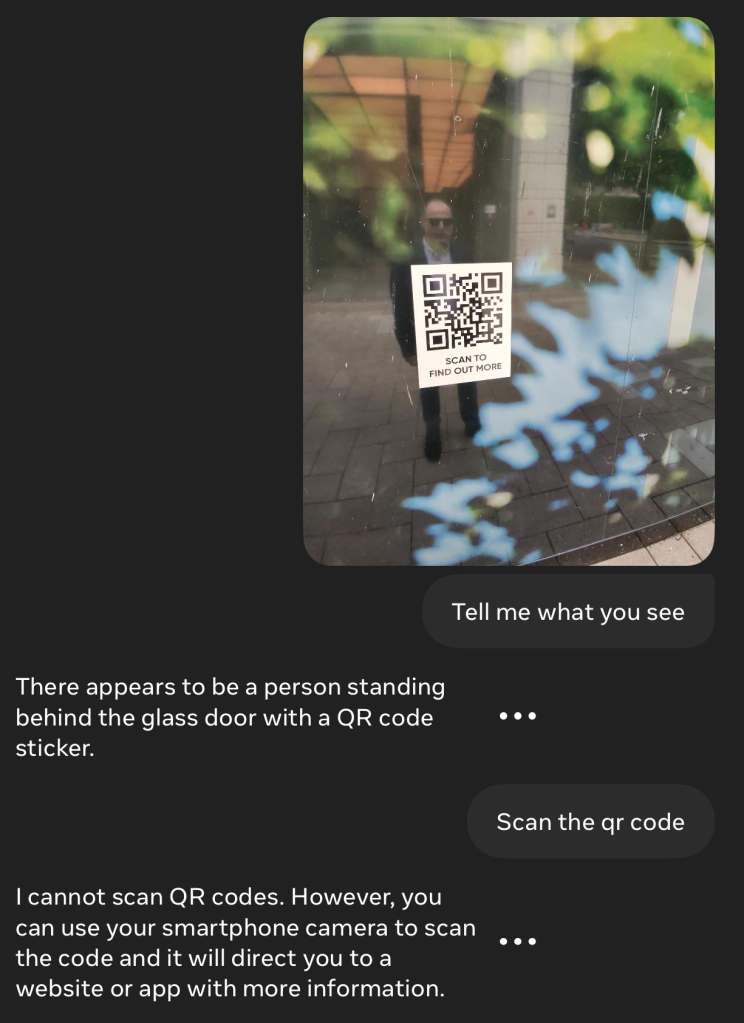

Она не может сканировать QR-коды (я прощу ее за то, что она приняла мое отражение за человека за дверью).

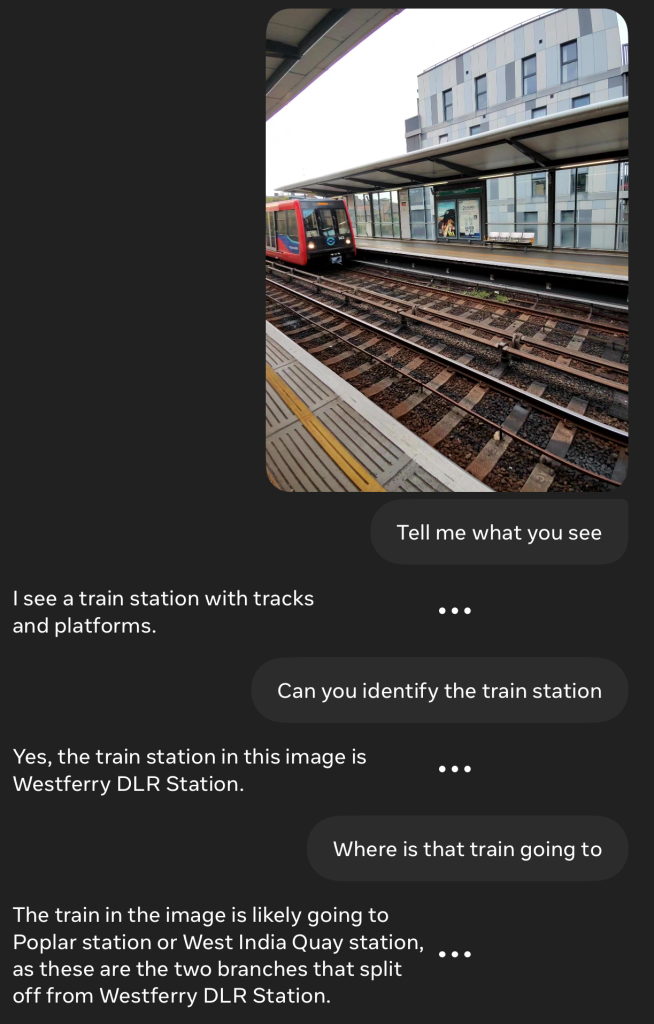

Наконец, это неплохо для работы без GPS и, по-видимому, визуального распознавания станции (возможно, читая вывеску, но я подозреваю, что нет, так как она обычно не читает текст, если он не очень близко):

Она определила возможные следующие остановки, а не пункт назначения. Но с доступом к CityMapper или подобному, она смогла бы дать гораздо более полезный ответ.

Итак, чего здесь не хватает — это специализация Apple

Meta использует Llama 2. OpenAI только что повысила ставки с GPT-4o. И ожидается, что Apple будет использовать смесь OpenAI и собственного движка ИИ.

Все это отличные новости. ИИ уже развивается феноменальными темпами, а конкуренция между компаниями только ускорит темпы улучшений. Присоединение Apple было бы хорошей новостью в любом случае.

Но представьте, что Apple привнесет свой фирменный экосистемный подход. Аппаратное и программное обеспечение работают вместе. Интеграция различных устройств для использования всех их возможностей. Вот что нужно, чтобы по-настоящему трансформировать этот вид технологий. Мне не терпится увидеть, что Apple с этим сделает.

Фото: Meta