Два года назад Apple объявила о ряде новых функций безопасности для детей, включая систему, которая будет использовать обработку на устройстве для сканирования материалов с сексуальным насилием над детьми. Несмотря на ориентированный на конфиденциальность подход к реализации этой функции, Apple столкнулась с таким сильным противодействием, что в итоге отказалась от своих планов.

Теперь Apple снова оказалась под давлением со стороны правозащитных групп и инвесторов-активистов, требующих принять более действенные меры против CSAM.

Как первым сообщило издание Wired, правозащитная группа по безопасности детей Heat Initiative запускает многомиллионную кампанию, в рамках которой она оказывает давление на Apple по этому вопросу. Сегодня утром мы сообщили об ответе Apple на кампанию Heat Initiative, в котором компания признала потенциальный прецедент внедрения функции обнаружения CSAM.

«Сканирование одного типа контента, например, открывает двери для массовой слежки и может создать желание искать другие зашифрованные системы обмена сообщениями по различным типам контента», — заявил в интервью Wired Эрик Нойеншвандер, директор Apple по конфиденциальности пользователей и безопасности детей.

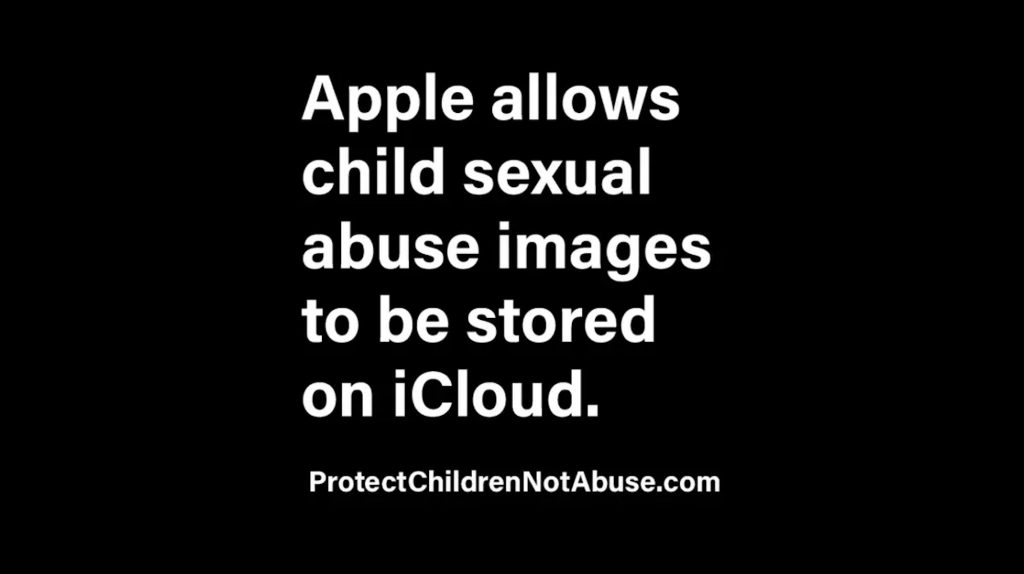

Теперь кампания Heat Initiative официально запущена. На сайте кампании Heat Initiative занимает агрессивную позицию по отношению к Apple. Кампания включает такие заявления, как: «Материалы с сексуальным насилием над детьми хранятся в iCloud. Apple это допускает».

Кампания объясняет:

Знаковое объявление Apple об обнаружении изображений и видео с сексуальным насилием над детьми в 2021 году было тихо отменено, что повлияло на жизни детей по всему миру. С каждым днем страдают дети из-за этого бездействия, поэтому мы призываем Apple выполнить свое обещание.

Правозащитная группа заявляет, что призывает Apple «обнаруживать, сообщать и удалять изображения и видео с сексуальным насилием над детьми из iCloud». Она также хочет, чтобы компания «создала надежный механизм отчетности для пользователей, позволяющий сообщать Apple об изображениях и видео с сексуальным насилием над детьми».

На сайте кампании также представлены несколько «Исследований случаев», в которых подробно описываются случаи хранения фотографий и видео сексуального насилия через iCloud. На сайте также есть кнопка «Написать руководству Apple напрямую». Эта кнопка открывает форму письма для массовой рассылки всему руководящему составу Apple.

Heat Initiative также направила письмо Тиму Куку, в котором группа утверждает, что бездействие Apple «ставит детей под угрозу».

В ходе нашего недавнего исследования мы столкнулись с сотнями случаев сексуального насилия над детьми, которые были задокументированы и распространены конкретно на устройствах Apple и хранились в iCloud. Если бы Apple обнаруживала эти изображения и видео, многие из этих детей были бы выведены из своих неблагополучных ситуаций гораздо раньше.

Именно поэтому в тот день, когда вы примете решение начать обнаруживать такой вредоносный контент, дети будут выявлены и больше не будут терпеть сексуальное насилие. Ожидание продолжает подвергать детей опасности и мешает пострадавшим или тем, кто имеет жизненный опыт, исцелиться.

Давление со стороны акционеров

Но помимо давления со стороны предстоящей рекламы Heat Initiative, Apple также вскоре столкнется с давлением со стороны инвесторов по этому вопросу. 9to5Mac стало известно, что Christian Brothers Investment Services планирует подать резолюцию акционеров, которая призовет компанию принять меры по улучшению обнаружения CSAM.

Christian Brothers Investment Services описывает себя как «католическая инвестиционно-управляющая фирма, придерживающаяся принципов социально ответственного инвестирования». Предполагается, что это предложение также сыграет роль в рекламной кампании Heat Initiative. Одновременно с этим, The New York Times также сообщает, что бельгийская инвестиционная фирма Degroof Petercam также поддержит эту резолюцию.

Как мы объясняли ранее, это ставит Apple в очень трудное положение. Сторонники конфиденциальности рассматривают первоначальное внедрение компанией обнаружения CSAM как опасный прецедент. В то же время, защитники прав детей утверждают, что компания делает недостаточно.

Хотя Apple отказалась от планов по обнаружению известных изображений CSAM при их хранении в iCloud, компания внедрила ряд других функций безопасности для детей.

Подпишись на Chance: Threads, Twitter, Instagram и Mastodon. Пожертвуй на поддержку Детской исследовательской больницы Святого Иуды.